网站 SEO 优化与抓取收录综合指南

ALice

在 SEO 的世界里,搜索引擎与网站的关系,就像读者与图书馆——你希望读者能尽快找到你的书,但前提是这本书必须被收录、分类,并摆放在正确的位置。SEO 的核心目标,就是让搜索引擎顺利“发现”并“理解”网站内容,从而在合适的搜索结果中展示给用户。

从技术层面的抓取与索引,到内容层面的排名与点击,每一步都环环相扣。想让网站在搜索结果中长期保持曝光,除了优质内容,更需要清晰的结构、正确的文件配置,以及对搜索引擎运行机制的理解。

本文将从六个方面展开,带你系统梳理 SEO 的基础结构和关键机制:包括 robots.txt 协议的作用、网站抓取与收录流程、索引与排名机制、用户点击与行为数据的重要性、sitemap.xml 文件的必要性,以及常见问题排查。这些环节共同构成了搜索引擎优化的底层逻辑,帮助网站在信息洪流中脱颖而出,获得持续而稳定的自然流量。

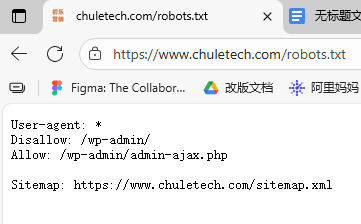

一、robots.txt协议的作用

robots.txt 是网站与搜索引擎之间公认的通信协议,用于告知搜索引擎哪些页面可以被抓取,哪些需要屏蔽。

robots.txt 文件在网站优化中扮演着重要的“守门人”角色。它通过向搜索引擎说明哪些页面可以被抓取、哪些需要屏蔽,帮助网站在隐私保护与内容曝光之间取得平衡。通过合理设置,网站可以阻止搜索引擎访问后台、登录页、测试页等不希望公开的部分,从而防止敏感信息泄露。同时,robots.txt 还能引导搜索引擎优先抓取核心内容页面,提高爬取效率,避免搜索引擎在无关路径上浪费抓取资源。除此之外,还可以在文件中指定网站地图(Sitemap)的位置,帮助搜索引擎更快了解网站结构,促进重要页面的收录。

二、网站抓取与收录流程

网站的抓取与收录是搜索引擎了解网页内容并决定是否展示给用户的重要过程。

一般来说,这个过程分为五个阶段:发现、抓取、解析、索引和展现。搜索引擎首先会通过外部链接、站点地图或以往的抓取记录找到新的网页地址,并将这些网址加入待访问列表。接着,爬虫程序会访问网站,读取 robots.txt 文件,判断哪些内容允许抓取。通过验证后,爬虫会进入页面,提取文字、图片、链接等关键信息,对网页结构和主题进行理解与分析。随后,搜索引擎会根据内容质量、相关性与用户体验等维度,将符合标准的页面纳入索引库,也就是我们常说的“收录”。最后,当用户搜索相关关键词时,系统会从索引库中调取最匹配的内容,并根据算法排序,展示在搜索结果页中。可以说,从被发现到出现在搜索结果里,是一场关于结构、内容与质量的持续筛选。只有那些清晰、优质且对用户有价值的页面,才能真正赢得搜索引擎的青睐。

三、索引与排名机制

搜索引擎的索引与排名机制,是决定网页能否出现在搜索结果页以及排在第几位的核心环节。

当网站内容被抓取后,搜索引擎会对页面进行整理和分类,把文字、图片、标题、链接等信息转化为结构化数据,存入庞大的索引库中。这个过程就像给互联网建一本巨大的“图书目录”——只有被收录进索引库的页面,才有资格参与后续的排名。

当用户输入搜索词时,搜索引擎会在索引库中快速检索匹配内容,并通过算法对候选页面进行综合评估。影响排名的因素很多,包括内容与关键词的相关性、网站权威度、外部链接质量、用户停留时间、加载速度以及移动端体验等。简单来说,搜索引擎不仅在比对“谁提到了关键词”,更在判断“谁能真正解答用户的问题”。

最终,那些结构清晰、内容优质、体验良好的页面,会获得靠前的展示位置。索引决定了页面能否进入赛场,而排名决定了它能否脱颖而出。对于网站运营者来说,理解并优化这两个环节,才是提升搜索曝光度的关键。

四、用户点击与行为数据的重要性

在搜索引擎的排名体系中,用户点击与行为数据正变得越来越重要。

过去,搜索引擎主要依靠网页内容、外链数量和关键词相关度来判断页面质量;而如今,用户行为已成为衡量“真实价值”的关键信号。当一个页面在搜索结果中获得较高点击率(CTR)、更长停留时间(Dwell Time)、较低跳出率时,搜索引擎会认为该页面能够有效满足用户需求,从而提升它在搜索结果中的排名。

相反,如果用户频繁点击进入后立即返回搜索结果,说明内容与标题不符或体验不佳,搜索引擎就会降低该页面的权重。这种“用户反馈机制”帮助算法不断优化结果排序,使搜索结果更贴近用户真实意图。

对网站来说,理解并优化用户行为数据至关重要。这不仅意味着要写出吸引点击的标题和摘要,更要在内容层面满足搜索意图、提升阅读体验。合理的排版、快速的加载速度、清晰的导航结构,以及有价值的内容,都会影响用户的停留与互动。可以说,在现代 SEO 中,搜索引擎关注的已经不只是“内容写得好不好”,而是“用户看得是否满意”。

五、sitemap.xml文件的必要性

在网站优化中,sitemap.xml 文件是帮助搜索引擎高效理解网站结构的关键工具。它相当于网站的“地图”,详细列出了站点中希望被搜索引擎抓取和收录的所有重要页面。对于大型网站或内容更新频繁的网站来说,sitemap.xml 几乎是不可或缺的。

搜索引擎在抓取网站时,并不会自动发现所有页面,尤其是那些层级较深或内部链接较少的内容。而 sitemap.xml 文件能主动告诉搜索引擎这些页面的存在,并提供每个页面的更新时间、更新频率和优先级信息。这样一来,即使某些页面没有被外部链接指向,搜索引擎仍能通过 sitemap 进行抓取和索引。

此外,sitemap.xml 还能显著提升新页面的收录效率。当你新增文章、产品页或栏目时,只要更新 sitemap 并提交给搜索引擎(如通过 Google Search Console),爬虫便能更快识别到这些变化,加速内容的曝光。

可以说,sitemap.xml 是网站与搜索引擎之间的“主动沟通渠道”。它不仅让网站结构更清晰,也让搜索引擎更精准地抓取重点内容。在 SEO 策略中,拥有一份结构合理、实时更新的 sitemap.xml 文件,是保障网站收录率与抓取效率的重要基础。

六、常见问题排查

在网站优化的日常工作中,常见问题的排查是一项基础却至关重要的环节。很多时候,网站收录不理想或排名波动,并非内容本身的问题,而是隐藏在技术细节里的“拦路虎”。

首先要检查的是 robots.txt 文件。不少站点因为误写了 Disallow: /,导致搜索引擎直接被拒之门外;或者遗漏了 Sitemap 路径,使爬虫难以及时发现新内容。其次,要确保 网站的可访问性正常。如果页面频繁出现 404、服务器响应缓慢、或存在复杂的重定向链,爬虫的抓取效率都会大打折扣。

另一个容易被忽略的细节是 meta 标签。若页面被设置了 <meta name=”robots” content=”noindex”>,无论内容多优质,也不会被收录。此外,重复内容与低质量页面同样会拉低网站整体权重,影响搜索引擎的信任度。

最后,还应定期检查 sitemap.xml 是否更新、页面加载速度是否达标,以及 内部链接结构是否合理。这些因素共同决定了网站的抓取深度与用户体验。

对编辑和优化人员来说,网站排查不是一次性的修复,而是一项持续性的维护。只有在结构清晰、内容优质、技术无障碍的前提下,网站才能在搜索结果中保持稳定而健康的表现。

七、结论

SEO 并不是一场短跑,而是一场需要耐心与系统思维的马拉松。它要求我们在技术、内容与用户体验之间找到平衡,让搜索引擎更高效地理解网站,也让用户更愿意停留与信任。无论是 robots.txt 的精准设置,还是 sitemap.xml 的及时更新,抑或是对抓取、索引、排名的持续优化,每一步都在为网站的长期增长打下基础。

在这个信息爆炸的时代,能被“找到”比被“看到”更重要。唯有不断优化结构、打磨内容、关注数据反馈,才能让网站在搜索结果中持续发声,真正实现从“被发现”到“被选择”的转变。SEO 不是单纯的技巧,而是一种让内容更有价值、让传播更有方向的思维方式。

上一篇: 外链运营综合指南

下一篇: sitemap站点地图综合指南

豫公网安备 50010702500968号

豫公网安备 50010702500968号