了解robots.txt的完整指南

Anna

在SEO优化中,robots.txt是一个容易被新手忽略,却对爬取效率、索引质量影响极大的核心文件。它就像网站给搜索引擎爬虫(如百度蜘蛛、Googlebot)的“访问说明书”,明确告知爬虫哪些页面可以爬取、哪些页面禁止爬取,直接影响网站的收录效率和权重分配。

一、什么是robots.txt

robots.txt是存放在网站根目录下的一个纯文本文件,遵循“机器人排除协议(Robots Exclusion Protocol)”,用于规范搜索引擎爬虫的爬取行为。

二、robots.txt的核心作用

节省爬虫抓取预算:爬虫每天能爬取的页面数量是有限的。如果网站存在大量无价值页面(如后台、登录页、重复页、测试页),会浪费爬取配额,导致核心页面(首页、栏目页、优质内容页)无法被及时爬取。

控制爬虫抓取范围:网站的后台管理页、用户中心、订单页等敏感页面,一旦被爬虫爬取收录,可能泄露隐私信息。通过robots.txt禁止爬取这类页面,可有效规避风险。

优化索引质量:无价值页面、重复内容页面即使被收录,也不会获得好排名,反而会拉低网站整体质量。robots.txt阻止爬虫爬取这类页面,可减少无效收录,让搜索引擎更聚焦于优质页面的索引,提升网站整体权重。

三、robots.txt的局限性

无法阻止“恶意爬虫”:仅对遵守机器人协议的主流搜索引擎爬虫有效,对恶意爬虫、采集工具无约束;

无法删除已收录页面:如果页面已被搜索引擎收录,仅通过robots.txt禁止爬取,无法直接删除收录。需结合noindex标签、提交删除申请等方式处理。

四、robots.txt核心语法

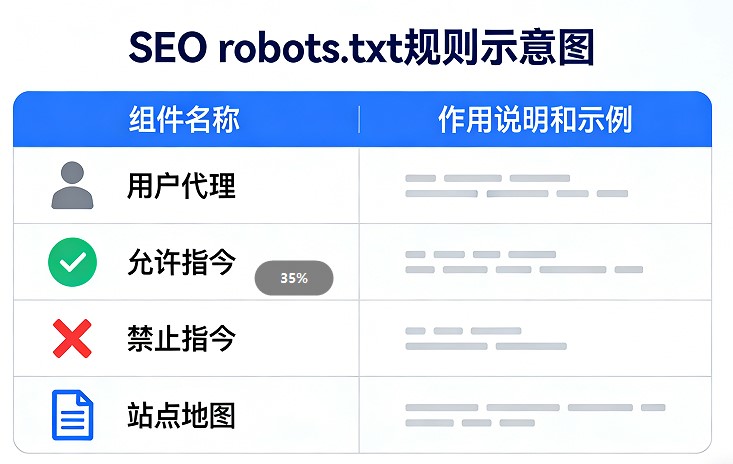

robots.txt语法简单,核心由“用户代理(User-agent)”“允许指令(Allow)”“禁止指令(Disallow)”“站点地图(Sitemap)”4个部分组成。

1. 核心语法组件解析

| 语法组件 | 作用说明 | 示例 |

| User-agent(用户代理) | 指定规则适用的搜索引擎爬虫(即“告诉哪个爬虫这些规则”)。* 代表所有爬虫;也可指定具体爬虫(如百度蜘蛛、Googlebot)。 | User-agent: *(所有爬虫)User-agent: Baiduspider(仅百度蜘蛛) |

| Disallow(禁止指令) | 指定禁止爬虫爬取的页面/目录。/ 代表网站根目录;空值(Disallow: )代表允许爬取所有页面。 | Disallow: /admin/(禁止爬取admin目录下所有页面)Disallow: /login.html(禁止爬取login.html页面) |

| Allow(允许指令) | 指定允许爬虫爬取的页面/目录(用于细化规则,当Disallow与Allow冲突时,Allow优先级更高)。 | Disallow: /article/(禁止爬取article目录下所有页面)Allow: /article/seo/(允许爬取article目录下seo子目录页面) |

| Sitemap(站点地图) | 告知爬虫网站的sitemap地址,引导爬虫快速爬取核心页面(非必需,但强烈建议添加)。 | Sitemap: https://www.xxx.com/sitemap.xml |

2. 语法编写注意事项

规则区分大小写:目录/页面地址区分大小写(如/Admin/与/admin/是两个不同目录),需精准填写;

符号使用规范:目录结尾需加/(如/admin/代表目录,/admin代表页面);* 可作为通配符(如Disallow: /*.html 代表禁止爬取所有html页面);

文件位置正确:必须放在网站根目录下(如https://www.xxx.com/robots.txt),放在子目录下无效。

五、robots.txt优化技巧

1. 精准筛选禁止爬取的页面

需明确:仅禁止以下4类无价值页面,核心页面一律不禁止:

管理类页面:后台、登录页、注册页(/admin/、/login.html);

测试类页面:测试页、临时页面(/test/、/temp/);

重复/无价值页面:标签页、归档页、搜索结果页、参数过多的筛选页;

敏感页面:用户中心、订单页、支付页(电商站/会员站重点)。

2. 结合sitemap,提升爬取效率

robots.txt中添加sitemap地址,可让爬虫快速找到网站的核心页面结构,减少爬虫遍历链接的时间,尤其适合页面较多的网站。注意:sitemap地址需填写完整的绝对地址(如https://www.xxx.com/sitemap.xml),而非相对地址。

3. 定期更新,适配网站结构变化

当网站新增栏目、删除页面、调整目录结构时,需及时更新robots.txt——比如新增了“会员中心”目录,需添加Disallow: /member/;删除了“测试页”目录,需删除对应的禁止规则,避免规则失效或误禁。

总结

robots.txt是SEO优化的“基础工具”,其核心价值在于精准分配搜索引擎的爬取配额、聚焦网站的核心页面,并有效提升整体索引质量。此外,建议在robots.txt中正确添加sitemap文件的链接,这能帮助搜索引擎更高效地发现和抓取网站的重要页面,形成良好的引导。最后,robots.txt并非一成不变,需要定期检查和更新,尤其是在网站结构调整、新增重要栏目或删除无效页面后,及时验证并修改规则,才能持续保持其最佳效果。

上一篇: 索引与收录的区别及优化全解析

下一篇: SEO锚文本优化全攻略

豫公网安备 50010702500968号

豫公网安备 50010702500968号